🔥 Benutzersignale: Das heimliche Rückgrat moderner Rankings

Benutzersignale sind längst keine „weichen Faktoren“ mehr, sondern der Kern fast aller modernen Rankingmodelle. Suchmaschinen werten nicht nur Klicks aus, sondern ganze Nutzer-Sitzungen: Wie tief scrollt jemand? Kommt er zurück? Schließt er nach zehn Sekunden entnervt den Tab? Oder liest er wirklich, interagiert, klickt weiter?

Die zugrunde liegenden Modelle — oft basierend auf Deep Semantic Similarity (DSSM), Attention-Modellen, BCLM oder komplexen Position-Bias-Korrekturen — berechnen, wie gut der Nutzer subjektiv zufrieden ist. Es geht also nicht mehr darum, ob deine Seite „objektiv“ gut ist, sondern ob sie Nutzern im Kontext ihrer Suche die richtige Erfahrung liefert.

Ein Text kann theoretisch perfekt sein – wenn Nutzer aber frustriert sind, sinkt er.

Ein mittelmäßiger Text mit klarer Struktur, Antworten im oberen Seitenbereich und sauberer Navigation kann dagegen stark performen.

Besonders wichtig ist die Synchronisation zwischen Anfrage (Query), Snippet (Title/Description) und dem, was Nutzer auf den ersten 5 Sekunden der Seite finden. Die Modelle vergleichen diese Ebenen miteinander – und wenn sie semantisch nicht zusammenpassen, gibt’s Abzug.

Benutzersignale sind außerdem kontextabhängig. Dein Ranking für dieselbe Suchanfrage kann sich je nach Tageszeit oder Nutzertyp ändern. Jemand mit Kaufabsicht reagiert auf dieselbe Seite anders als ein Research-User – und das wird live in die Bewertung eingepreist.

💡 Tipps für bessere Benutzersignale

- Packe die wichtigste Antwort ganz oben auf die Seite – „Above the fold“ entscheidet oft das ganze User-Signal.

- Baue Interaktionen ein: Akkordeons, Tabellen, Tools, Rechner, Vergleichsboxen.

- Optimiere Titles nicht als Clickbait, sondern als semantisches Versprechen, das du im Text sofort einlöst.

- Nutze „NPS-Style“-Elemente wie „War dieser Artikel hilfreich?“ – simple Tricks für bessere Experience-Signale.

- Erzeuge „Micro-Branding“: Je mehr Menschen deine Brand suchen, desto höher fallen User-Signale aus (höheres Vertrauen).

🔗 Links: Nicht tot, aber völlig anders gewichtet als früher

Links sind weiterhin ein bedeutender Rankingfaktor — aber sie funktionieren heute anders. Suchmaschinen verlassen sich weniger auf reine Backlink-Zahlen und stärker auf Kontext, Erwähnungen und Vertrauen.

Erwähnungen ohne Link (Brand Mentions) werden inzwischen oft ähnlich stark gewertet wie ein Link selbst, vorausgesetzt der Kontext stimmt. Das liegt an entity-basierten Modellen, die Marken, Themen und Websites als „Wissensknoten“ verstehen.

Auffällig ist, dass bestimmte Plattformen — darunter Wikipedia, VK, Rumbler und erstaunlicherweise auch TikTok — eigene Sonderfaktoren besitzen. Ein Wikipedia-Link ist nicht einfach ein Link, sondern ein Vertrauenssignal auf Systemebene. Erwähnungen dort, selbst ohne Link, sind überproportional wertvoll.

Gleichzeitig wird immer stärker geprüft, ob dein Linkprofil „natürlich“ wirkt. Modelle erkennen unnatürliche Muster, überoptimierte Anchor-Texte oder Linknetzwerke heute verblüffend gut.

Linkaufbau ist nicht tot – er ist nur intelligenter geworden. Markengetriebener, PR-getriebener Content performt besser als klassische Outreach-Mails. Und: Thematische Nähe zählt deutlich mehr als Domain Authority.

💡 Tipps für moderne Linksignale

- Setze auf Themenautorität statt Masse: Wenige, sehr relevante Links schlagen viele schwache.

- Baue echte PR auf: Studien, Tools, Daten, Visualisierungen → extrem linkfähig.

- Hol dir Wikipedia-Erwähnungen über zitierbare Ressourcen (Grafiken, Datensätze, Glossare).

- Sorge für Brand-Mentions in Communities (Reddit, X, Quora, Foren) – wirkt stärker als alter „SEO-PR“.

- Vermeide harte SEO-Anchor-Texte – nutze natürliche Sprache, genau wie Journalisten es tun würden.

📝 Content-Relevanz: Semantik schlägt Keywords (und ML entscheidet)

Content wird heute nicht mehr an Keywords gemessen, sondern an semantischer Dichte, Themenabdeckung, Lesbarkeit und Modellverständnis.

Die Rankingmodelle in modernen Suchmaschinen bestehen aus mehreren Schichten: Embeddings, Attention-Module, Cosine-Matching, BCLM-Mix-Modelle, Übersetzungs- und Qualitätsdetektoren. Jede Schicht bewertet etwas anderes.

Wichtig:

Diese Modelle gewichten nicht „viel Text“, sondern gut organisierten Text.

Sie erkennen, ob ein Thema vollständig erklärt ist, ob wichtige Subfragen fehlen, ob die Struktur logisch ist, und ob der Text auf menschliche Weise geschrieben ist.

Sehr interessant:

Automatisch übersetzter Inhalt wird zuverlässig erkannt – selbst wenn er stilistisch okay aussieht. Modelle erkennen syntaktische Muster aus maschinellen Übersetzungen. Wer übersetzt, muss also manuell feinjustieren lassen.

Was ebenfalls steigt: die Bedeutung von „themenbezogenen Entitäten“. Es reicht nicht, über „SEO Tools“ zu schreiben – du musst auch zugehörige Begriffe einbetten: z. B. Rankingmodelle, Crawling, Embeddings, Indexbereinigung, usw.

Je mehr ein Text das „Informationsnetz“ eines Themas abbildet, desto höher das semantische Scoring.

💡 Tipps für moderne Content-Relevanz

- Schreibe modular: Hauptthema + Subthemen + Micro-Topics → sorgt für semantische Tiefe.

- Ergänze Inhalte mit Entitäten, nicht nur Keywords (z. B. Tools, Begriffe, Prozesse).

- Vermeide maschinische Übersetzungen ohne Redaktion – Modelle erkennen das eindeutig.

- Nutze klare Strukturierungen (H2/H3), damit Attention-Modelle Informationen leichter extrahieren.

- Ergänze Beispiele, Analogien und konkrete Use-Cases – ML-Modelle lieben kontextreiche Passagen.

🛡️ Qualität & Vertrauen: E-A-T ist nicht tot – es ist nur unsichtbarer geworden

Qualität und Vertrauen waren früher vor allem redaktionelle Konzepte. Heute sind es messbare, modellbasierte Signale. Und sie gehen wesentlich tiefer als klassische E-A-T-Empfehlungen.

Moderne Rankingmodelle prüfen nicht nur den Content, sondern das gesamte Vertrauensumfeld einer Website: Autoren, Quellen, Versionierung, thematische Kontinuität, Nutzerfeedback, externe Erwähnungen, Domain-Historie, technische Sauberkeit und sogar den „Tonfall“ einer Seite.

Besonders wichtig ist die Autorenschaft. Suchmaschinen bewerten, ob ein Autor:

– konsistent zu einem Themenbereich schreibt,

– qualitativ hochwertige Inhalte veröffentlicht,

– extern erwähnt wird,

– im Kontext einer Branche digitale Spuren hinterlässt.

Damit hat sich die Logik verschoben: Nicht nur die Domain, auch der Mensch dahinter ist ein Rankingfaktor.

Trust entsteht heute außerdem durch Datentiefe, Quellenverweise, Transparenz (Wie? Warum? Woher?) und eine klare inhaltliche „Handschrift“. Seiten, die wie anonym zusammengeschraubt wirken, verlieren — egal wie gut der Text kurzfristig erscheint.

Ebenfalls stark gewichtet: Domainhistorie und Konsistenz.

Domains, die regelmäßig publizieren, ein stabiles Themenumfeld behalten und wenig experimentieren, genießen höhere Grundwerte.

Wer dagegen dauernd Themenwechsel, redesigns, 301-Kaskaden oder Content-Explosionen hinlegt, riskiert, dass Modelle die Seite als instabil einstufen.

💡 Tipps für Qualität & Vertrauen

- Setze auf sichtbare Autorinnen & Autoren mit echten Profilen, Fotos, Bios, Expertise.

- Verlinke vertrauenswürdige, belegbare Quellen — am besten Primärquellen.

- Verwende eine klare redaktionelle Struktur und einheitlichen Stil.

- Aktualisiere Inhalte regelmäßig, aber ohne hektische, sprunghafte Layoutwechsel.

- Zeige Transparenz: „So haben wir die Daten analysiert“, „So funktioniert der Prozess“, usw.

⚖️ YMYL: Die 15 Zusatzfaktoren, die alles verändern

In sensiblen Themen (Medizin, Recht, Finanzen, Sicherheit) gelten strenge Regeln.

Suchmaschinen haben hier ganze Sondermodelle, die separat bewertet werden – insgesamt 15 Faktoren, die ausschließlich für YMYL gelten.

Hier geht es weniger um Keywords, mehr um:

1. fachliche Verlässlichkeit

Inhalte müssen Experten widerspiegeln – medizinische Autoren, Juristen, Finanzexperten.

„Redaktions-Content“ ohne Expertise fällt sofort durch.

2. Risikoabschätzung

Modelle prüfen, ob der Inhalt potenziell schädliche Empfehlungen gibt.

Reißerische Ratschläge (“Verdopple dein Geld in 7 Tagen”) sind toxisch.

3. Quellenqualität

Nicht jede Quelle zählt gleichermaßen.

Peer-Reviewed > Studien > Behörden > Medien > Blogs.

4. Strukturierte Korrektheit

YMYL-Content braucht klare Gliederung, Disclaimer, objektive Sprache.

5. Konsistenz mit Branchenwissen

Ungewöhnliche oder extrem abweichende Behauptungen werden stark abgewertet.

YMYL-Seiten dürfen keine Grauzonen haben.

Das Rankingmodell bewertet, wie sehr der Inhalt dem „Stand des Wissens“ entspricht und ob der Autor die notwendige Kompetenz hat.

💡 Tipps für YMYL-Inhalte

- Nutze echte Experten als Autoren – ideal mit verifizierbarem Hintergrund.

- Baue medizinische oder juristische Hinweise explizit als Disclaimer ein.

- Verlinke hochwertige Studien, Behörden, Institute.

- Vermeide Marketing-Sprache – YMYL verlangt Neutralität.

- Aktualisiere YMYL-Inhalte häufiger als andere Themen (mind. alle 6–12 Monate).

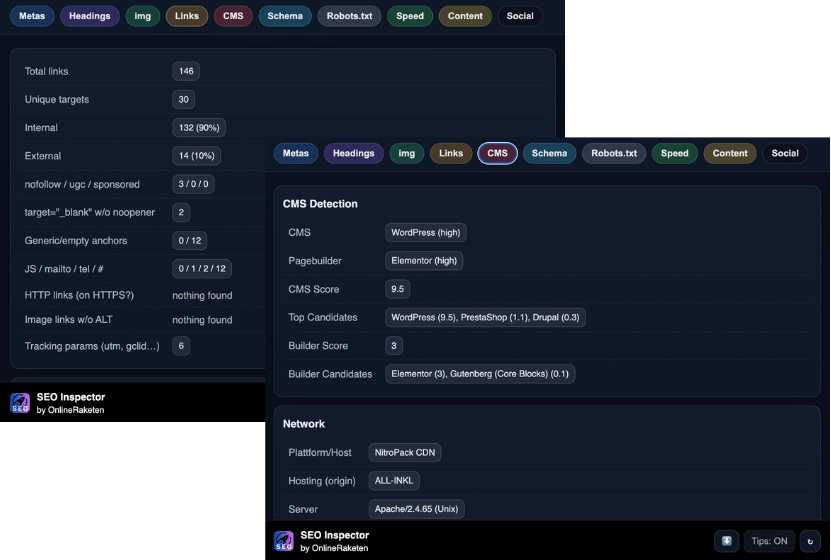

⚙️ Technik: HTTPS, Geschwindigkeit, Scripte & Tracking – der Unsichtbare Rankingbooster

Technische Signale sind nicht die stärksten Rankingfaktoren, aber sie wirken wie Multiplikatoren. Eine hervorragende Seite kann mit schlechter Technik tief fallen; eine technisch saubere Seite kann mediocre Inhalte immerhin stabil halten.

Wichtige technische Elemente:

HTTPS

Sicherheitsstatus ist ein harter Faktor. Kein HTTPS = massives negatives Signal.

Ladezeit

Page Speed fließt ein, aber subtil. Nicht Geschwindigkeit selbst zählt, sondern Nutzererlebnis.

Langsame Seiten → schlechte Nutzer-Signale → Verstärkung des negativen Effekts.

Tracking-Scripts

Sehr spannend:

Bestimmte Scripte wie Google Analytics, Yandex Metrica oder Facebook JavaScript besitzen jeweils eigene Faktoren.

Positive Wirkung: Nutzersignale werden präziser erfasst.

Negative Wirkung: Zu viele Scripte verlangsamen die Seite oder erhöhen Datenschutzrisiken.

JavaScript allgemein

Zu komplexe JS-Architekturen können Inhalte für Suchmaschinen verzögern oder blockieren.

Client-Rendering ist immer ein Risiko.

Saubere URL-Struktur

Viele Faktoren im Dokument betreffen URL-Parsing, Parameter, Verzeichnislogik – technische Klarheit zahlt sich aus.

💡 Tipps für Technik

- Nutze Server Side Rendering (SSR) für Inhalte, die indexiert werden sollen.

- Entferne überflüssige Scripte – besonders veraltetes Tracking.

- Teste regelmäßig deine Struktur: 404s, Weiterleitungen, Canonicals.

- Optimiere LCP, CLS und TTFB – aber ohne technische Obsession: Nutzererlebnis zählt.

- Halte URLs einfach, kurz und ohne exotische Parameter.

⏰ Zeitfaktoren: Ja, Rankings ändern sich je nach Tageszeit – und zwar systematisch

Eine der überraschendsten Entdeckungen sind die 10 zeitabhängigen Rankingfaktoren.

Sie wirken auf Basis von:

- Tageszeit

- Wochentag

- Nutzerverhalten zu diesen Zeiten

- historischer Vergleichsdaten

- saisonalen Mustern

- Device-typischen Aktivitätsfenstern (z. B. Desktop vs. Mobile)

Das erklärt, warum Rankings oft am Wochenende oder abends anders aussehen.

Die Logik:

Nutzer verhalten sich morgens anders als abends.

Sie klicken länger, kürzer, anders — und diese Verhaltensmuster fließen live in Rankings ein.

Suchmaschinen „wissen“, wann User besonders kaufbereit, scrollfreudig oder eher informativ unterwegs sind.

Abends mehr Recherche, tagsüber mehr „ich will es jetzt kaufen“.

Suchmaschinen passen sich entsprechend an.

💡 Tipps für zeitabhängige Faktoren

- Analysiere Rankings nach Tageszeit – nicht nur „einmal täglich“.

- Plane Veröffentlichungen zu Zeiten, wo hohe Scrolltiefe typisch ist.

- Optimiere Conversion-Elemente für die Zeiten, in denen User kaufbereit sind.

- Passe Inhalte an: abends längere Artikel, morgens klare, schnelle Antworten.

- Nutze SERP Live Testing, um Schwankungen besser zu verstehen.

🌐 Plattform-Sonderregeln: TikTok, Wikipedia, VK & Rumbler

Ein faszinierender Bereich sind die plattformabhängigen Sonderregeln.

Diese Plattformen haben eigene Faktoren im Rankingmodell:

- TikTok (3 zusätzliche Regeln)

- Wikipedia

- VK

- Rumbler

Das bedeutet:

Diese Seiten erzeugen überdurchschnittlich starke Signale, wenn sie dich erwähnen.

Warum?

Sie gelten für ML-Modelle als High-Trust-Patterns.

Wikipedia → sehr hohes Quellvertrauen

TikTok → extrem starkes Nutzerverhalten

VK/Rumbler → Relevanz für bestimmte Sprach- und Kulturkreise

TikTok ist besonders spannend:

Virale TikTok-Erwähnungen wirken wie Boosts für Brand-Suchen – und damit indirekt für Rankings.

💡 Tipps für Plattform-Signale

- Versuche Wikipedia-Erwähnungen über Daten, Glossare oder Grafiken.

- Nutze TikTok für Micro-Branding – Erwähnungen wirken stärker als Tweets.

- Baue Social Proof in relevanten Märkten (z. B. VK für Osteuropa) gezielt auf.

- Verlinke Social-Aktivitäten nicht zwingend – Erwähnungen allein reichen als Signal.

- Beobachte, welche Plattform in deiner Branche „dominante Entität“ ist – dort musst du auftauchen.

🕵️♂️ Anti-Spam & Manipulationserkennung: Der stille Wächter im Rankingmodell

Moderne Suchmaschinen investieren enorm viel Rechenleistung in die Erkennung von Manipulationen. Während früher simple Muster wie Keyword-Stuffing, Link-Farmen oder Duplicate Content ausreichten, um das System auszutricksen, sind die heutigen Anti-Spam-Algorithmen eher mit Fraud-Detection-Systemen von Banken vergleichbar.

In deinem Datensatz finden sich Hunderte Parameter, die eindeutig auf Manipulationsfilter, Risikoscores und Verhaltensanomalien hinweisen. Viele Faktoren tragen Tags wie TG_DYNAMIC, TG_USER, TG_BOOST, TG_FAKE, TG_UNDOCUMENTED — klassische Indikatoren für Modelle, die versuchen, nicht nur Content zu erkennen, sondern auch die Absicht dahinter.

Wichtig zu verstehen:

Suchmaschinen bestrafen nicht einzelne Fehler. Sie bestrafen Muster.

Beispiel:

Ein schlechter Link ist egal.

Hundert schlechte Links in derselben Woche → Muster → Risiko.

Ein mittelmäßiger Text fällt nicht auf.

30 Artikel im gleichen Stil, gleicher Syntax, gleicher Satzmelodie → Muster → mögliche Automatisierung → Risiko.

Diese Modelle sind heute ungeheuer gut darin, künstliche Textmerkmale zu identifizieren – selbst dann, wenn der Text „gut klingt“. Syntaktische Homogenität, fast gleich lange Sätze, fehlende semantische Abweichungen, monotone Entitätenmuster: alles Alarmsignale.

Auch zu schnelle Verbesserungen gelten als verdächtig.

Wenn eine Seite plötzlich +600 % Traffic in 14 Tagen bekommt, wird ein Audit getriggert, bei dem u. a. Backlinks, Nutzersignale, Ladezeiten und Seitenstruktur erneut gescannt werden.

Es ist also wichtig, dass SEO-Wachstum „organisch aussieht“ – selbst wenn man es bewusst erzeugt.

Außerdem:

Nicht nur was du tust, sondern wie plötzlich du es tust, entscheidet darüber, ob ein Spam-Flag gesetzt wird.

💡 Tipps zur Vermeidung von Spam-Signalen

- Baue Links langsam und zyklisch auf, nicht in „Wellen“.

- Varriere Satzbau, Stilmittel, Struktur – organischer Content wirkt chaotischer.

- Erstelle keine 20 ähnlichen Artikel zum gleichen Keyword → „Pattern Detection“-Alarm.

- Vermeide technische Sprünge wie massive 301-Wellen oder plötzliche URL-Explosionen.

- Nutze menschliche Redaktion – Modelle erkennen syntaktische „Maschinenmuster“.